薪资高、机会多、缺口大,让大数据在开发圈里成了香饽饽。

与此同时,在我做公众号的这两年,目睹了太多人「从入门到放弃」,甚至有些人连大数据的门都没进来。看看你是哪种?

在中小企业做了一段时间大数据,但是只做大数据全流程中的一小块工作,对整个流程啊、怎么选型都没啥概念,而且公司的数据量级也不够,跳槽到大厂很难。

自学了一阵大数据,只学到了皮毛不说,根本没有数据库去模拟存储计算,简历上也只敢写「了解」某某技术,最后连份工作都找不到。

想转行大数据,苦于入行无门......

上面这几种情况,一看就是没经历过真实项目,也没有受过系统训练导致的,我们做大数据的薪酬是高,但门槛也是高,因为不管你是什么级别,所需要的技术栈你都应该用过,否则,别说大厂了,进中小企业都难。

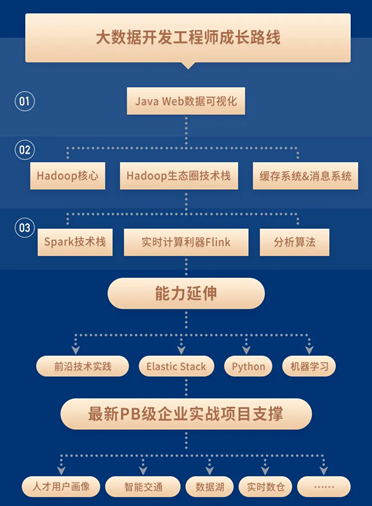

那么,大数据究竟怎么学?今天,跟大家聊一聊我的学习路径和方法。

第 1 阶段,掌握Java Web数据可视化。你需要掌握Java服务器端技术,前端可视化技术,数据库技术,这个阶段主要是储备大数据的前置技能,当然你已经可以从事数据可视化工程师的工作了,但还不能算真正入门大数据。

第 2 阶段,学会 Hadoop 核心及生态圈技术栈。这部分涵盖的技术比较多,像 HDFS 分布式存储、MapReduce、Zookeeper、Kafka等你都得掌握,掌握后可以去从事 ETL 工程师等一些大数据的岗位,但是知识储备还不够完整。

第 3 阶段,搞定计算引擎及分析算法。计算引擎我建议是 Spark 和Flink 都能熟练使用,虽然现在一些企业还在用 Spark,但未来 Flink 一定会成为主流。学到这,你已经具备相对完整的大数据技能,能从事一些高薪的岗位了,像大数据研发工程师、推荐系统工程师、用户画像工程师等。

IDEA激活码

IDEA激活码